ニューラルネットワーク学習の本質:最適化・目的関数・勾配降下法・誤差逆伝播のしくみ

はじめに

こんにちは、Altam Easeの本田直輝です。

近年、AIや機械学習があらゆる分野で活用されるようになっています。その中心技術のひとつが「ニューラルネットワーク」です。本記事では、ニューラルネットワークの学習における核心的な仕組み――つまり「最適化問題」「目的関数」「勾配降下法」「誤差逆伝播法」について、初心者の方でも理解できるように、丁寧に解説します。

学習は「最適化問題」

ニューラルネットワークの学習は、数学的には「最適化問題」として捉えることができます。

「重み(パラメータ)を調整して、損失関数(誤差)を最小にする」

という問題を解いているのです。

目的関数(損失関数)とは?

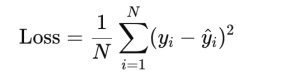

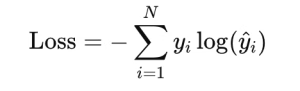

モデルの出力 y^ と、正解ラベル y のズレを表す関数であり、以下のような形式があります

回帰問題:平均二乗誤差(MSE)

分類問題:クロスエントロピー

最小化のための「勾配降下法」

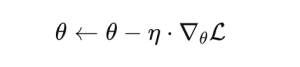

最適化のために使われるのが、勾配降下法(Gradient Descent)です。

基本の更新式:

η:学習率(Learning Rate)

L:損失関数の勾配(パラメータに対する傾き)

これにより、損失を減らす方向へ少しずつ進んでいくことができます。

勾配法のバリエーション

| 手法 | 特徴 |

|---|---|

| SGD(確率的勾配降下法) | データ1件ずつで更新。ノイズが多いが高速。 |

| Mini-Batch SGD | 数十件ごとに更新。実務でよく使われる。 |

| Adam / RMSprop | 勾配の平均や変化を考慮し、安定性が高い。 |

勾配をどう求める?「誤差逆伝播法」

モデルの学習において最も重要な技術が、誤差逆伝播法(Backpropagation)です。

-

順伝播:入力 → 出力 を計算

-

ロス計算:正解とのズレを求める

-

逆伝播:ロスを元に、各層の重みに関する勾配を逆方向に計算

-

重み更新:勾配を使って、重みを少し修正

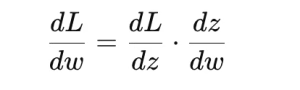

連鎖律(Chain Rule)がカギ

勾配の計算は連鎖律を使って行います。

これにより、複雑な層構造を持つネットワークでも、正確に勾配を求めることができます。

全体の学習の流れ

[入力 x]

↓

[順伝播: モデル出力 ŷ を計算]

↓

[ロス関数: ŷ と正解 y のズレを計算]

↓

[逆伝播: ロスから各重みへの勾配を計算]

↓

[勾配降下法: 重みを更新し、再び順伝播へ]

↓

[繰り返し: ロスが十分小さくなるまで]

おわりに

ニューラルネットワークの学習は、表面的には「たくさんのデータを流して重みを調整する」だけに見えるかもしれません。しかし実際には、「最適化問題を勾配を使って解く」という数学的な美しさが背後にあります。

これらの基本を理解することで、深層学習の実装やチューニング、さらには独自モデルの開発にも役立つはずです。

この記事へのコメントはありません。