機械学習の基礎を理解する:最適化・勾配法・過学習・汎化性能とは?

こんにちは。Altam Ease代表の本田直輝です。

機械学習モデルを作る際に必ず登場する用語が「最適化」「勾配法」「過学習」「汎化性能」です。これらは、モデルの精度や信頼性を左右する極めて重要な概念です。本記事では、それぞれの意味と関係性について、初心者にも分かりやすく整理します。

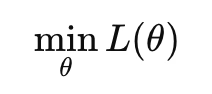

最適化とは?

最適化とは、ある目的を達成するためにベストな状態(最小値または最大値)を見つける作業のことです。機械学習においては、主に「ロス関数(損失関数)を最小化する」という形で使われます。

▷ 数式イメージ:

-

L(θ):ロス関数(損失を表す関数)

-

θ:モデルのパラメータ(重みやバイアス)

このように、ロス関数の最小化は最適化問題の一種であることが分かります。

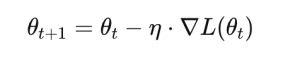

勾配法とは?最適化のための手段

「最適化をどうやって実現するか?」という問いに対する答えの一つが勾配法(Gradient-based Method)です。

▷ 仕組み:

勾配(関数の傾き)を使って、関数の値が小さくなる方向にパラメータを少しずつ更新していきます。

▷ 一般的な更新式:

-

:学習率(step size)

-

∇L(θt):勾配(偏微分)

| 手法 | 特徴 |

|---|---|

| 勾配降下法(GD) | 全データの勾配で更新。精度は高いが計算が重い |

| 確率的勾配降下法(SGD) | 1件ずつのデータで更新。ノイズは多いが高速 |

| ミニバッチ法 | 小さなグループで更新。実用的な中間解 |

| Adam / Momentum | 勾配の履歴や学習率の自動調整を加える手法。深層学習で定番 |

過学習とは?

過学習(Overfitting)とは、モデルが学習データに過剰に適合しすぎてしまい、未知のデータに対してはうまく予測できなくなる現象です。

▷ 例:

訓練データの細かなノイズや例外を覚えすぎてしまう

結果として、訓練データには強いが、テストデータには弱いモデルができてしまう

▷ 症状:

指標 状態

訓練誤差:小さい

テスト誤差:大きい → 過学習の可能性大

▷ 防止策:

対策 内容

正則化(L1/L2) パラメータの大きさを抑える

ドロップアウト ニューラルネットの一部を無効化して学習

早期終了 テスト誤差が上がり始めた時点で学習停止

データ拡張・増加 より多く・多様なデータを使う

モデルの簡素化 複雑すぎる構造を避ける

汎化性能とは?

汎化性能(generalization ability)とは、「訓練に使っていないデータに対しても正しく予測できる力」のことです。

▷ 言い換えると:

「このモデルは本番環境でちゃんと使えるか?」を測る指標

▷ 例え話:

教科書の問題は完璧に解けるが、模試や応用問題が解けない生徒 → 過学習、汎化性能が低い

教科書の内容を応用して新しい問題も解ける生徒 → 汎化性能が高い

▷ 評価方法:

方法 内容

ホールドアウト法 データを訓練・検証・テストに分けて評価

交差検証(K-Fold) 複数の分割で平均スコアを計算し信頼性アップ

テスト専用データ ハイパーパラメータ調整と独立した評価用データを使い分ける

この記事へのコメントはありません。