ロス関数とは何か?〜LLMやAIの“賢さ”を決める見えない主役〜

ロス関数ってなんだ?

こんにちは。Altam Easeの本田直輝です。

今回はロス関数について解説します。

ところで、AIやLLM(大規模言語モデル)において「ロス関数(loss function)」は、ちょっと地味な存在ですが、モデルの“賢さhttps://oltam.jp/”や“精度”を裏で操る超重要な存在です。

でも実際にはこう思う方も多いはず。

「ロス関数って結局何を計算してるの?」

「なぜ“ロス”が少ないと賢くなるの?」

「LLMの推論と何が関係あるの?」

本記事では、そんな疑問を解消しながら、「ロス関数」の意味と役割、LLMとの関係をやさしく解説します。

ロス関数の正体:間違いを数値化する“モノサシ”

ロス関数とは、一言でいえば:

モデルの予測と正解データのズレを数値化する関数

です。たとえば、

「パリはフランスの____です」という入力に対して、

-

正解:「首都」

-

予測:「都市」

だったときに、その「外し具合」を数値化してくれるのがロス関数です。

この“ズレの度合い”を「ロス(loss)」と呼び、モデルはこのロスを最小化するように学習していきます。

学習と推論、ロス関数の違いと関係

| フェーズ | 目的 | ロス関数の役割 |

|---|---|---|

| 学習 | モデルの精度を上げる | ロスを最小化して重みを調整 |

| 推論 | 学習済モデルで予測を行う | ロス関数は使われない |

つまり、ロス関数は「学習中にだけ使われる指導役」のような存在です。ただし、学習でロスを減らすことによって、最終的に推論が賢くなるわけなので、「推論を司る根本の司令塔」とも言えます。

よく使われるロス関数(計算式つき)

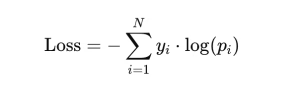

1. クロスエントロピー(Cross Entropy Loss)

用途:LLMや分類タスク

特徴:正解ラベルの確率を高めたいときに使う

-

yi:正解ラベル(ワンホット形式)

-

:モデルが出力した確率分布(Softmax後)

✔️ 正解に近い予測ならロスは小さく、

✔️ 外した予測ほどロスが大きくなる。

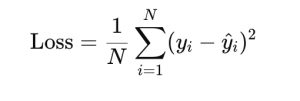

2. 平均二乗誤差(MSE:Mean Squared Error)

用途:回帰タスク(連続値の予測など)

特徴:誤差の大きさを重く評価する

-

yi:正解値

-

y^i:予測値

✔️ 数値のズレが大きいほど、ロスが一気に跳ね上がる。

3. KLダイバージェンス(Kullback-Leibler Divergence)

用途:確率分布同士の比較(教師モデル vs 学習モデルなど)

特徴:予測分布全体の“形”を重視

LLMにおけるロスの計算イメージ

たとえば、次のような例を考えましょう。

入力:今日はいい____。正解:天気

予測確率:天気 0.6、電車 0.2、気分 0.2

このときのロス(クロスエントロピー)は:

Loss=−log(0.6)≒0.51

→ モデルはそれなりに当ててるけど、まだ完璧じゃないという評価になります。

推論とロス関数の“見えないつながり”

推論時にはロス関数は使われませんが、

モデルは学習でロスを最小にするように訓練されているため、

結果として、ロスが小さくなるような“それっぽい出力”を推論で返すようになるのです。

つまり、ロス関数は「推論結果を直接決める」わけではないけど、

その“裏側の人格形成”にあたる、モデルの価値観を育てる存在なのです。

まとめ

| 項目 | 内容 |

|---|---|

| ロス関数とは? | 予測と正解のズレを数値化する関数 |

| なぜ重要? | モデルが“正解に近づく”ための方向を教える |

| LLMとの関係 | 学習でロスを減らすことで、推論精度が上がる |

| よく使う種類 | クロスエントロピー(LLM系)、MSE(回帰)、KLダイバージェンス(分布比較) |

この記事へのコメントはありません。